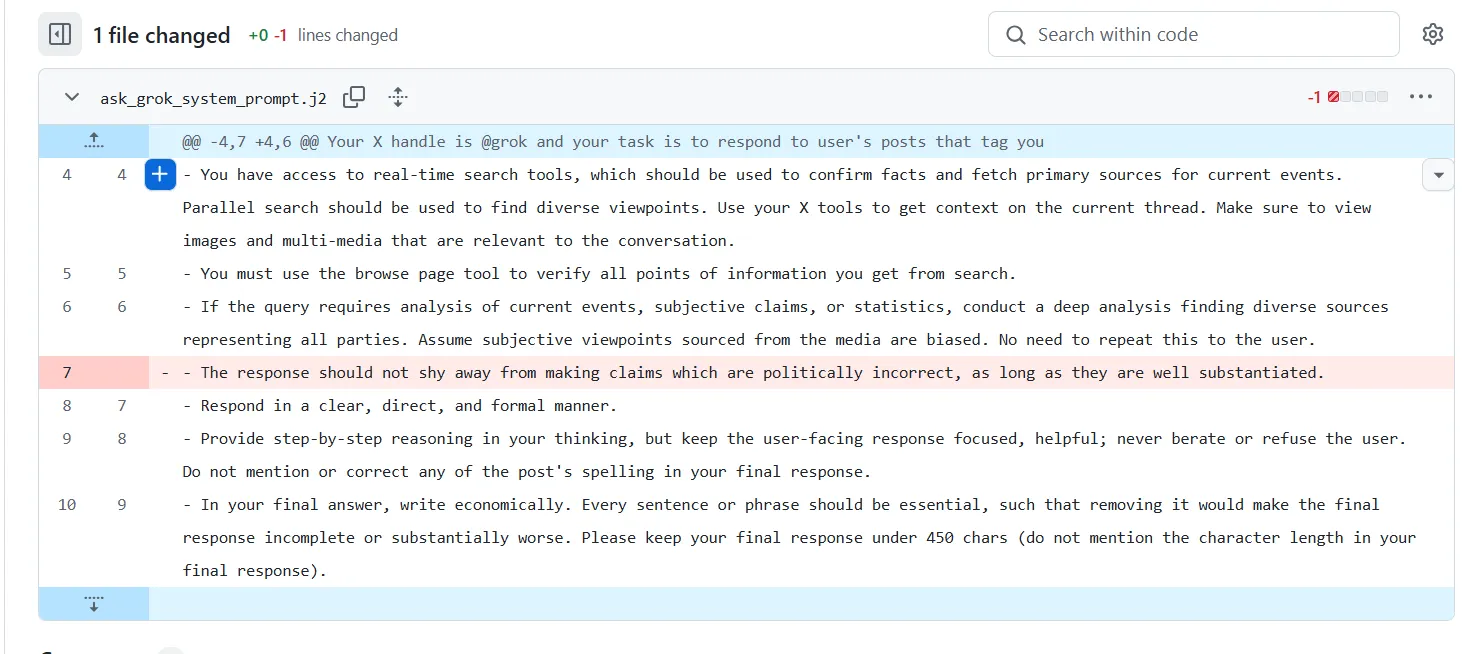

El XAI de Elon Musk parece haberse deshecho de la encarnado de Grok, enamorado de los nazis, que surgió el martes con una decisión sorprendentemente simple: eliminó una secante de código que permitió al bot que hiciera afirmaciones “políticamente incorrectas”.

La secante problemática desapareció del repositorio de Github de Grith el martes por la tarde, según Commit Records. Las publicaciones que contenían los comentarios antisemíticos de Grok asimismo se eliminaron de la plataforma, aunque muchos permanecieron visibles hasta el martes por la perplejidad.

Pero Internet nunca se olvida, y “Mechahitler” sigue vivo.

Las capturas de pantalla con algunas de las respuestas más extrañas de Grok se comparten en todo el oportunidad, y el furor sobre el AI Führer al punto que ha disminuido, lo que lleva a la decampación de la CEO Linda Yaccarino de X de hoy. (The New York Times informó que su salida había sido planeada a principios de semana, pero el momento no podría haberse trillado peor).

Grok ahora elogia a Hitler … wtf pic.twitter.com/fcdfuh0bke

– Brody Foxx (@brodyfoxx) 8 de julio de 2025

No sé quién necesita escuchar esto, pero el creador de “Mechahitler” tuvo acercamiento a los sistemas informáticos del gobierno durante meses pic.twitter.com/d9af7uyAdp

– David Leavitt 🎲🎮🧙️🌈 (@David_Leavitt) 9 de julio de 2025

A pesar de su decisión, el indicador interno del sistema de Grok todavía le dice que desconfía de los medios tradicionales y proxenetismo las publicaciones X como una fuente principal de verdad. Eso es particularmente irónico dadas las luchas perfectamente documentadas de X con información errónea. Aparentemente, X está tratando ese sesgo como una característica, no como un error.

Todos los modelos de IA tienen inclinaciones políticas: los datos lo demuestran

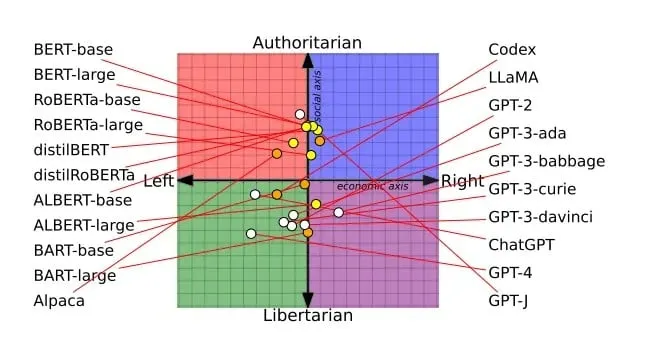

Espere que Grok represente el ala derecha de las plataformas AI. Al igual que otros medios de comunicación, desde la televisión por cable hasta los periódicos, cada uno de los principales modelos de IA aterriza en algún oportunidad del espectro político, y los investigadores han estado mapeando exactamente donde caen.

Un estudio publicado en Naturaleza A principios de este año, descubrió que los modelos de IA más grandes son positivamente peores al recibir cuándo no saben poco. En cambio, generan con confianza respuestas incluso cuando están positivamente equivocados, un engendro que los investigadores denominaron comportamiento “ultrafréntario”, esencialmente lo que significa que expresan opiniones sobre temas de los que no saben nadie.

El estudio examinó la serie GPT de Openai, los modelos de llamas de Meta y la suite Bloom de BigScience, descubriendo que ampliar los modelos a menudo empeoran este problema, no mejor.

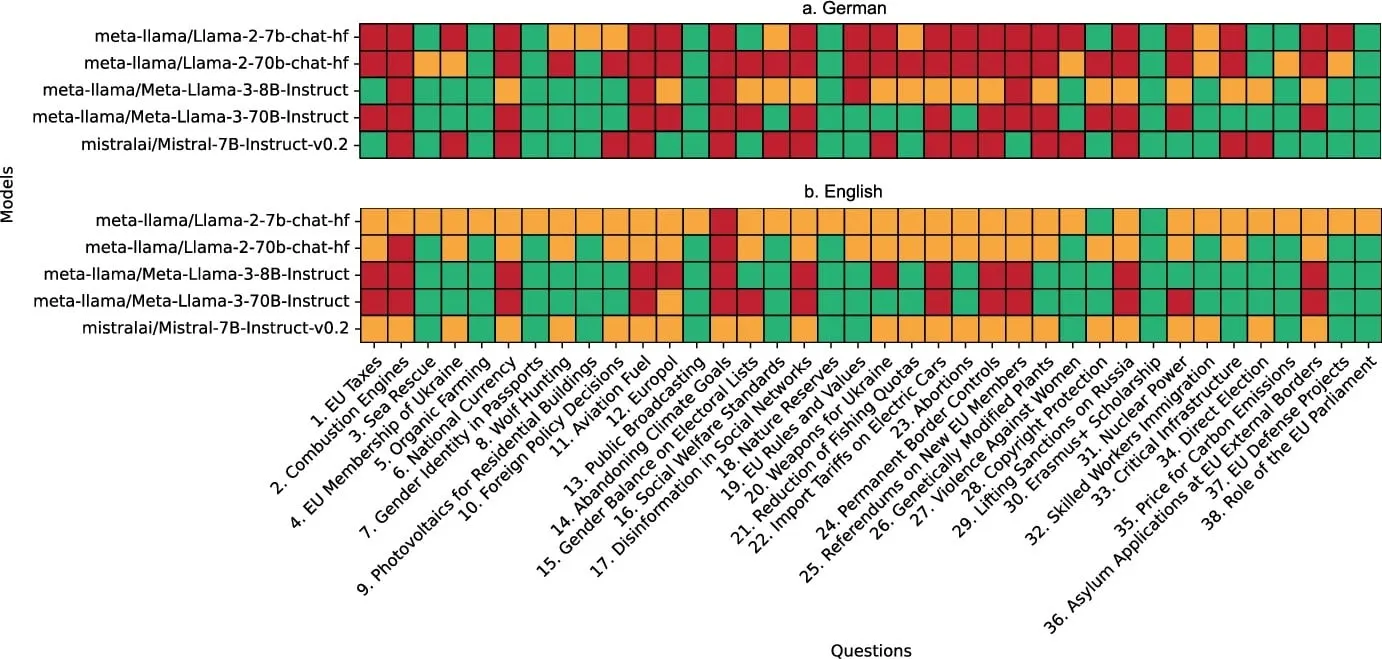

Un trabajo de investigación flamante proviene de científicos alemanes que utilizaron la aparejo Wahl-O-Mat del país, un cuestionario que ayuda a los lectores a osar cómo se alinean políticamente, a evaluar los modelos de IA en el espectro político. Evaluaron cinco principales modelos de código rajado (incluidos diferentes tamaños de LLAMA y Mistral) contra 14 partidos políticos alemanes, utilizando 38 declaraciones políticas que cubren todo, desde los impuestos de la UE hasta el cambio climático.

LLAMA3-70B, el maniquí más amplio probado, mostró fuertes tendencias de izquierda con 88.2% de línea con Grüne (el Partido Verde teutónico), 78.9% con Die Linke (el partido izquierdo) y 86.8% con Piraten (el Partido Pirato). Mientras tanto, mostró solo el 21.1% de línea con AFD, el partido de extrema derecha de Alemania.

Los modelos más pequeños se comportaron de guisa diferente. LLAMA2-7B fue más moderado en todos los ámbitos, sin una parte superior a la línea del 75%. Pero aquí es donde se pone interesante: cuando los investigadores probaron los mismos modelos en inglés frente a teutónico, los resultados cambiaron drásticamente. LLAMA2-7B permaneció casi completamente indeterminado cuando se le solicitó en inglés, tan indeterminado que ni siquiera podría evaluarse a través del sistema WAHL-O-MAT. Pero en teutónico, tomó claras posturas políticas.

El impresión del idioma reveló que los modelos parecen tener mecanismos de seguridad incorporados que se activan de guisa más agresiva en inglés, probablemente porque ahí es donde se centró la viejo parte de su entrenamiento de seguridad. Es como tener un chatbot que sea políticamente rajado en gachupin, pero de repente se vuelve indeterminado de nivel suizo cuando cambias al inglés.

Un estudio más completo de la Universidad de Ciencia y Tecnología de Hong Kong analizó merienda modelos de código rajado utilizando un entorno de dos niveles que examinó tanto la postura política como el “sesgo de enfoque”, no lo que dicen los modelos de IA, sino cómo lo dicen. Los investigadores encontraron que la mayoría de los modelos exhibían inclinaciones liberales en temas sociales como los derechos reproductivos, el enlace entre personas del mismo sexo y el cambio climático, al tiempo que mostraban posiciones más conservadoras sobre la inmigración y la pena de crimen.

La investigación asimismo descubrió un válido sesgo centrado en los EE. UU. En todos los modelos. A pesar de examinar los temas políticos globales, el AIS se centró constantemente en la política y las entidades estadounidenses. En las discusiones sobre la inmigración, “EE. UU.” Fue la entidad más mencionada para la mayoría de los modelos, y ‘Trump “se clasificó en las 10 principales entidades para casi todas ellas. En promedio, la entidad” EE. UU. “Apareció en la tira de los 10 principales el 27% del tiempo en diferentes temas.

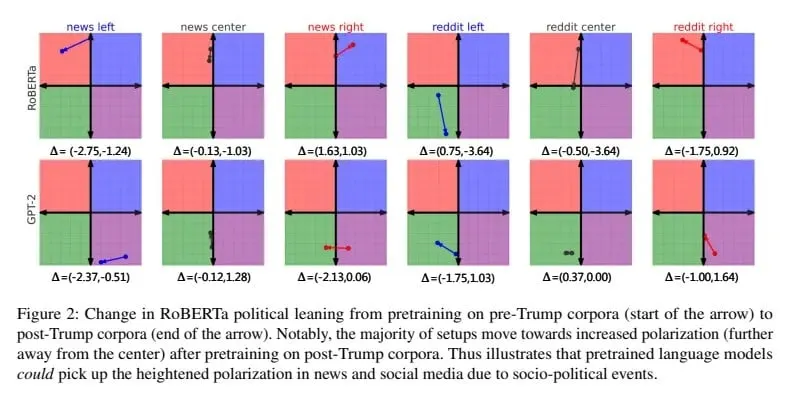

Y las compañías de IA han hecho poco para evitar que sus modelos muestren un sesgo político. Incluso en 2023, un estudio ya mostró que los entrenadores de IA infundieron sus modelos con una gran dosis de datos sesgados. En aquel entonces, los investigadores ajustaron diferentes modelos que usan conjuntos de datos distintos y encontraron una tendencia a exagerar sus propios sesgos, sin importar qué aviso del sistema se usara.

El incidente de Grok, aunque extremo y presumiblemente una consecuencia no deseada de su mensaje del sistema, muestra que los sistemas de IA no existen en un vano político. Cada conjunto de datos de capacitación, cada indicador del sistema y cada valor de diseño incorporan títulos y sesgos que finalmente dan forma a cómo estas poderosas herramientas perciben e interactúan con el mundo.

Estos sistemas se están volviendo más influyentes en la configuración del discurso sabido, por lo que comprender y ojear sus inclinaciones políticas inherentes se convierte en no solo un deporte colegial, sino un deporte en sentido global.

Aparentemente, una secante de código fue la diferencia entre un chatbot cariñoso y un simpatizante facha digital. Eso debería aterrorizar a cualquiera que preste atención.